近年来,随着人工智能与AIGC技术的迅猛发展,计算机图形学领域成为了科研热点。作为该领域的年度盛会, SIGGRAPH(ASIA) 会议汇聚了全球顶尖的学者和工业界专家,提供了一个展示最新研究成果和推动技术进步的平台。我有幸获得了这次宝贵的参会机会,以展示我们团队的研究成果。此次会议于2024年12月3日-12月6日在日本举行,我与许岚课题组和虞晶怡课题组共20人一同参加前往。一起参会的还有虞晶怡院长,许岚教授等。

随着数字世界和现实世界之间的界限逐渐模糊,3D和4D内容正在迅速崛起,重塑社会对数字景观的期望和应用。在这些创新中,体积视频作为一种创新的视频格式,代表了视觉媒体的变革性进步,它允许观众从任意视角进行观看,使观众能够得到沉浸式的虚拟体验。然而在高保真人体姿态渲染和实时播放方面,高效地渲染真实的人体表现并将其集成到沉浸式设备中仍然是一个挑战。在此背景下,我们的团队开发了DualGS,一种基于双层高斯的显式方法,用于从密集镜头中进行高保真人体性能渲染,并将其集成到VR/AR等多种平台中。

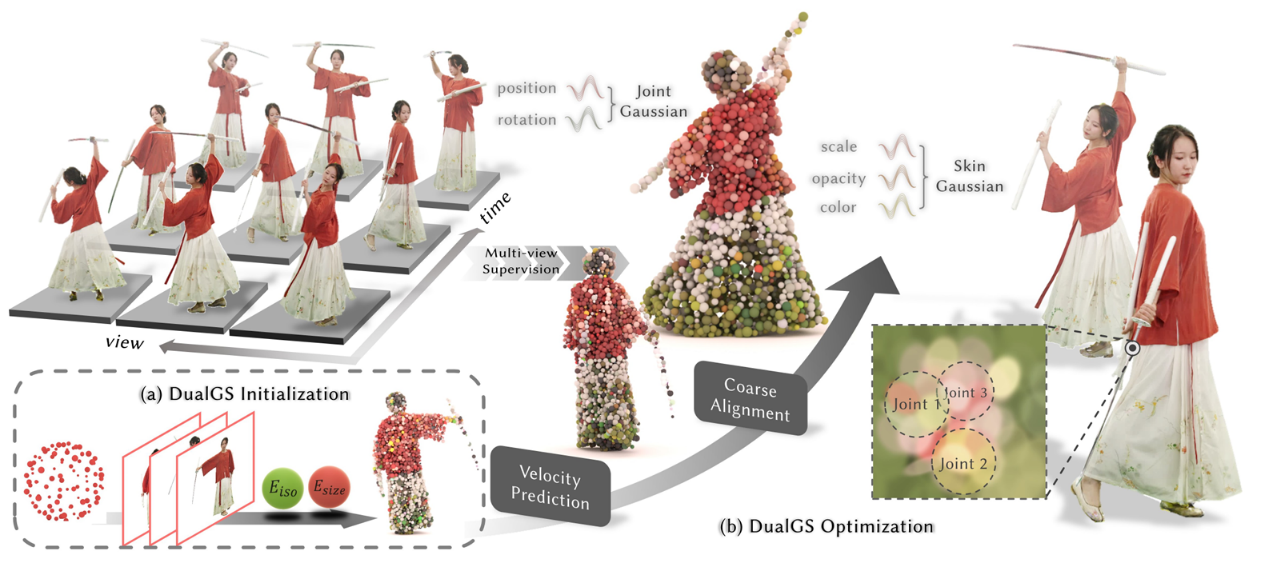

在SIGGRAPH会议期间,我们团队展示了题为“Robust Dual Gaussian Splatting for Immersive Human-centric Volumetric Videos”的汇报。在展示过程中,我们详细介绍了DualGS的方法和优势。

双层高斯训练策略:在序列训练中,该研究优化了DualGS的关节和皮肤高斯,观察到高斯倾向于通过改变外观而非位置适应光度损失。为此,该研究采用从粗到细的训练策略,从粗略对齐开始,逐步细化以优化动作追踪和渲染质量,并且通过预测新帧位置和应用非刚性约束,该研究控制高斯的运动,避免不合理变形。

双层高斯训练策略

双层高斯压缩方法:该研究利用双层高斯表达对于颜色和动作的解耦能力,对于高斯的不同属性分别提出了残差量化压缩,图片编解码压缩和可持久化码本的压缩方法。得益于DualGS提供的有效解耦,该方法能够分别从关节高斯和皮肤高斯中有机地压缩运动和外观,实现了高达120倍的压缩比,同时仍能实时解码出高保真的渲染结果。

在展示过程中,我们与许多参会者进行了深入交流。很多研究人员对我们的研究表现出了浓厚的兴趣,并提出了许多有价值的问题和建议。例如,有参会者询问我们的方法在处理复杂动作时的性能,以及在不同平台上的适应性。我们详细解释了我们的算法如何通过自适应时空正则化器来保持高质量渲染,同时展示了我们在不同平台上的实验结果。此外,我们还讨论了一些可能的改进方向,如进一步优化分割算法以减少由于分割错误导致的渲染伪影。

进行fast-forward的分享

进行论文细节的汇报

在SIGGRAPH(ASIA) 会议期间,我们与来自全球的顶尖研究人员和行业专家进行了深入交流。通过参加各种讲座和展示,我们了解了许多最新的研究进展和技术趋势。这些交流不仅开阔了我们的视野,还为我们未来的研究工作提供了许多新思路。例如,通过与其他研究团队的讨论,我们发现了将我们的高斯分布方法应用于更多动态场景的潜力,并探讨了与他们合作的可能性。

此外,在展示我们的研究成果时,我们收到了来自与会人员的宝贵反馈。这些反馈帮助我们识别了当前方法的不足之处,并提出了许多改进建议。例如,有与会者建议我们在处理人体与物体交互时,进一步优化分割算法,以减少由于分割错误导致的渲染伪影。此外,我们还了解到一些新的优化技术,可以加速我们的4D高斯优化过程,这些建议将帮助我们在未来的研究中不断改进和提升我们的技术。

总的来说,此次SIGGRAPH(ASIA)会议之行非常成功。我们不仅展示了我们的研究成果,还通过与全球顶尖研究人员的交流,获得了许多宝贵的反馈和合作机会。未来,我们将继续努力,致力于推动高保真人体渲染技术的发展,为虚拟现实和增强现实等领域带来更多创新和突破。

沪公网安备 31011502006855号

沪公网安备 31011502006855号