我非常荣幸能参加“International Conference of Computer Vision”(ICCV2019),这也是我第一次参加国际性会议。ICCV由美国电气和电子工程师协会(IEEE)主办,每两年在世界范围内召开一次,是计算机视觉领域最高级别的国际性会议。今年的ICCV于2019年10月27日至11月3日在韩国首尔召开,本次会议吸引了来自全世界超过7000名研究人员,100多家人工智能公司参会,就人工智能现在的热点问题,前沿技术以及落地技术展开讨论。本届ICCV共投稿4303篇文章,其中共有1075篇文章接收,接收率为25%,其中仅有200篇文章被选作Oral presentation,占比为4.6%。

值得一提的是,我作为共同一作发表的文章“Pose Aware Multi-level Feature Network for Human Object Interaction Detection” 在本次大会作了Oral presentation。我们这篇文章在于解决检测人与物体的交互关系的问题,在这个任务中,由于人与物体交互方式的多样性以及交互场景的复杂性,以及交互关系在细粒度上的差异性,使得该任务相比于传统的视觉任务存在更多的挑战。我们提出了一种多层级(multi-level)的交互关系识别策略,包括交互区域、物体、人体关键部位三个层级;具体来说,本文提出了一种多分枝网络结构的模型,该模型利用人体姿态信息,通过基于注意力的机制动态放大(Zoom-in)交互关系相关的人体语义区域以增强该交互关系的局部特征,并在此基础之上对全局特征进行融合,从而进一步提高模型对于人与物体交互的细粒度检测能力。最后我们的模型在目前常用的benchmarks上都达到了state of the art,同时我们的模型也有较好的可解释性。

在参会期间,我聆听了很多视觉领域的学者和研究人员对他们研究方向作的详细报告,也与很多该领域的学生就学术问题进行了深刻的交流。我与何旭明老师以及课题组同学在10月26日从上海出发到韩国首尔,于11月3日回到上海。在此期间,我在10月27至10月28日以及11月2日分别参加了多场workshops,其中包括模型可解释性的探索,视觉与语言结合的研究以及视觉场景图生成(Scene Graph Generation)等等。

图1. 模型可解释性workshop

这些workshops会让很多在该领域很有影响力的学者分享他们对问题的理解,并介绍他们在该领域所做的一些工作。在这些talk之中,让我印象尤为深刻的是Alan Yuille教授介绍他们的关于对物体部位的定位的可解释工作。他们探索了物体的一些基本的visual concept,并把该物体的表示分解成这一系列visual concept的组合,每个visual concept作为landmark对物体定位有一个guidance,而最终物体的定位可以分解成一系列visual concept定位的投票(voting)。这么一来该模型可以有效地解决物体遮挡(occlusion)情况,并且最终的预测可以由投票结果来解释。

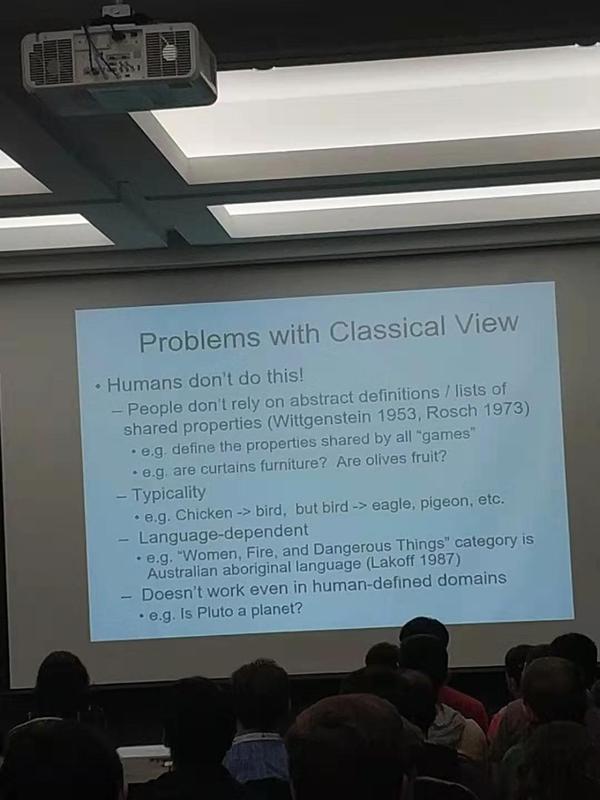

10月29至11月01日是正式会议时间,在此期间我们一方面向其他人展示我们的工作,另一方面也向其他人虚心学习。我听了很多的口头报告(oral presentation)以及参观了很多书面报告(poster presentation),其中有许多与我的研究方向一致或相关的工作,通过聆听与交流,我获益匪浅。在此之中,我个人感兴趣的工作主要集中于视觉场景理解(Visual Scene Understanding)和视觉语言结合(Vision-Language Integration),我与很多该方向的研究人员就该方向的难点与挑战进行了探讨,并对未来进行了展望。同时,我也与许多志同道合的研究人员建立了联系,方便在未来进行进一步的学术探讨。

除了学术界的很多学者参与了此次会议,同时还有大约100家企业也参与了此次盛会。我坚信对于计算机视觉领域学界的参与是非常必要的,一方面有很多经验丰富的学者同时在大企业的研究所兼职,他们愿意把学识经验落地为实地应用,这对于一个行业的健康发展极其重要;另一方面企业对于一些研究问题能提供一些独特的视角和可行性分析,这能让学术研究少走很多弯路。我参观了很多公司的展台并与很多公司研究人员进行了交流,使我的眼界得到了极大的扩展。

总体而言,此次出国交流经历让我受益匪浅。一方面能分享我们的工作,给了我一个展示的舞台,另一方面让我增长了见识,知道了我所在领域的进展与未来的方向。我非常感谢学校和何旭明老师给我这么一个机会,希望以后能做出更有意义的工作。

图2. 我们的现场Poster

图3. 语言表达是视觉的瓶颈

沪公网安备 31011502006855号

沪公网安备 31011502006855号