在2023年12月5日至12月11日,我有幸代表我们的研究团队参加在新加坡举办的自然语言处理领域的国际顶级会议——EMNLP 2023。这次会议不仅是一个学术交流的平台,也是我个人学术旅程中的一次重要经历。在这一周的时间里,我不仅展示了自己的研究成果,还深入了解了该领域的最新进展,并与来自世界各地的同行建立了联系。

本次出访团队由我、屠可伟老师、楼超博士学长和陈卓同学组成。我们的主要目的是在EMNLP 2023上进行两篇论文的poster展示,分别是《Joint Entity and Relation Extraction with Span Pruning and Hypergraph Neural Networks》和《Simple Hardware-Efficient PCFGs with Independent Left and Right Productions》。此外,我们也计划通过参加会议的各种环节,了解领域的最新研究动态,并与行业内的专家学者进行交流。EMNLP 2023聚集了来自全球的自然语言处理专家学者,会议内容丰富多彩,包括了主题报告、论文展示、poster交流以及专题研讨会等多个环节。

我特别关注了如何将人机交互(HCI)融入到NLP产品设计中的讲座。这一部分内容对我启发很大,讲者深入浅出地介绍了如何利用HCI设计原则来提升NLP产品的用户体验,尤其是在大规模语言模型(如LLMs)的应用中。会议中有两篇论文给我留下了深刻印象。一是《Knowledge is a Region in Weight Space for Fine-tuned Language Models》,该论文提出了一个新颖的观点,即通过微调,预训练模型的参数会收敛到与特定任务和能力相关的参数空间区域。另一篇是《CRaSh: Clustering, Removing, and Sharing Enhance Fine-tuning without Full Large Language Model》,它探讨了大型模型训练中参数层面的相似性和规律性,提出了一种更高效的模型训练方法。同时还有许多有趣的工作,有的工作探讨了传统的计算语言学中的句法分析问题,这和我之前的研究方向非常接近,我也被他们对于计算语言学的热情所打动,同时也再次被计算语言学的算法之美所感动。还有许多非常新的工作在本次会议上进行展示,有许多大模型的优秀工作,为大家揭示了大模型可能的潜在能力,为未来的思考方向奠定了非常好的方向。

我在poster展示环节接受了众多同行的提问。这两个小时的时间里,我不仅介绍了我们的研究成果,还与许多专家学者进行了深入的学术讨论。这不仅加深了我对自己研究的理解,也让我学到了如何更有效地进行学术交流。让我印象比较深刻的是,有深耕structured predictions的同行到访,问了我许多对于大语言模型时代的信息抽取的看法,我们借poster为契机,不仅探讨了我们已经完成了的研究工作,同时一起思考和讨论了结构化预测未来的发展。

通过与来自世界各地的专家学者的交流,我对自然语言处理领域的最新进展有了更全面的认识。尤其是一些前沿的研究方法和思想,为我未来的研究工作提供了宝贵的灵感。研究能力的提升:在准备和参加poster展示的过程中,我不仅提升了自己的表达能力,也学会了如何更有效地展示自己的研究成果,并从他人的提问中发现自己研究的不足之处。同时,在与同行进行国际交流的过程中,我也发现了自己存在的其他方面的不足,比如英语的口语和线下交流能力还不够熟练,不能真正做到准确、快速的表达自己的想法,这也是我之后需要去特别留意的,懂得如何向他人讲述自己的工作和想法,也是研究中非常重要的一环。此次会议让我结识了许多领域内的新朋友。我们相互分享了对大语言模型的看法,这不仅拓宽了我的学术视野,也为未来的国际合作奠定了基础。

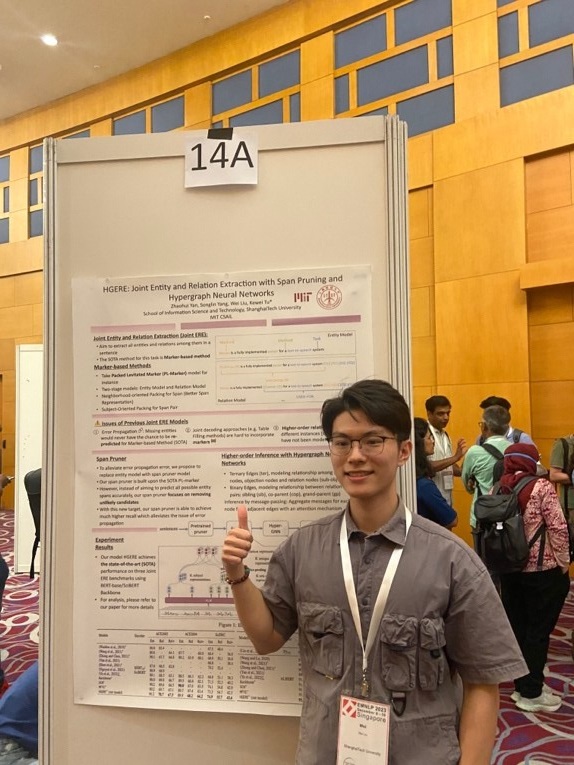

图为我同我们工作的海报合影

此次出访新加坡参加EMNLP 2023会议,不仅是一次展示我们研究成果的机会,更是一个深入了解自然语言处理领域最新动态、与国际同行交流和合作的宝贵平台。我不仅在学术上获得了丰富的收获,个人能力也得到了显著提升。这次经历对于我的学术生涯和个人发展具有不可估量的重要意义,我将以此为契机,继续在自然语言处理领域深耕细作,不断探索和进取。处在大语言模型的交叉路口,本次的出国访问机会为我后续的研究和思考,起到了非常大的促进作用,也为我对未来的研究有了新的看法。感谢学校和老师提供的本次机会!

沪公网安备 31011502006855号

沪公网安备 31011502006855号